ในยุคที่ปัญญาประดิษฐ์ (AI) เข้ามามีบทบาทสำคัญต่อการดำเนินธุรกิจและการใช้ชีวิตประจำวัน เราจำเป็นต้องเข้าใจว่า AI ไม่ใช่แค่เครื่องมือธรรมดา แต่เป็นเทคโนโลยีที่สามารถใช้งานได้หลากหลาย ส่งผลให้ผู้ใช้มีอิทธิพลต่อผลลัพธ์ที่เกิดขึ้น เปรียบเสมือนกับค้อนที่สามารถใช้ตอกตะปูหรือทำกิจกรรมอื่น ๆ ได้ จึงควรเตรียมความพร้อมและสร้างความเข้าใจให้กับบุคลากรและผู้มีส่วนได้ส่วนเสีย เพื่อป้องกันความเสี่ยงไม่ว่าจะเป็น ความเสี่ยงที่เกิดจากการกระทำโดยเจตนา (Intentional) เช่น Deepfake Scam หรือ Autonomous Weapons และความเสี่ยงที่ไม่ได้เกิดจากความตั้งใจ (Unintentional) เช่น ความผิดพลาดโดยไม่เจตนา หรือภัยธรรมชาติ ซึ่งเป็นปัญหาหลักที่องค์กรควรให้ความสำคัญ โดยรวมถึงข้อมูลที่ AI ใช้ในการเรียนรู้เกิดความลำเอียง (Bias Training Data) AI สร้างข้อมูลหรือเนื้อหาที่ไม่ถูกต้อง ไม่เป็นความจริง หรือไม่สมเหตุสมผล (Hallucination) คำแนะนำหรือการตัดสินใจที่ผิดพลาด ปัญหาลิขสิทธิ์ เป็นต้น

โดยเฉพาะอย่างยิ่ง หากท่านผู้อ่านเป็นผู้บริหารแล้ว ควรทำความเข้าใจและจัดการความเสี่ยงจาก AI อย่างรอบด้านผ่านคำถาม ดังนี้

- ใครบ้างที่ได้รับผลกระทบ? ทั้งทางตรงและทางอ้อมจากปัญหาที่อาจเกิดขึ้นกับ AI

- ปัญหาที่จะพบ เป็นอันตรายที่เคยเกิดขึ้นแล้ว หรือเป็นเพียงโอกาสที่อาจเกิดขึ้นในอนาคต? เพื่อจัดสรรทรัพยากรรับมือได้อย่างเหมาะสม

- เป็นปัญหาเฉพาะของ AI หรือเป็นปัญหาเดิมขององค์กรที่มีอยู่แล้ว ที่ AI เข้ามาขยายผลให้รุนแรงขึ้น?

- ใครควรเป็นผู้รับผิดชอบความเสียหาย? ไม่ว่าจะเป็นผู้ใช้ ผู้พัฒนา ผู้ร่วมวิจัยข้อมูล

หรือผู้ให้บริการแพลตฟอร์ม ควรมีการกำหนดความรับผิดชอบที่ชัดเจน - ความเสียหายที่เกิดขึ้นมีสาเหตุมาจากเจตนาร้ายหรือความประมาทเลินเล่อ?

- ความไม่ถูกต้อง (Inaccuracy) ของ AI จนส่งผลกระทบอาจรุนแรง เช่น กรณีระบบตรวจจับการฉ้อโกงของหน่วยงานสวัสดิการที่อยู่อาศัยในประเทศอังกฤษ ที่พบว่า 2 ใน 3 ของเคสที่ AI ตรวจจับไม่เป็นความจริง ทำให้กระบวนการล่าช้าและผู้เดือดร้อนไม่ได้รับความช่วยเหลือ ซึ่งปัญหาจากความไม่ถูกต้องนี้อาจกระทบต่อสิทธิของผู้รับบริการ เพิ่มภาระงานของบุคลากร และสร้างภาพลักษณ์เชิงลบต่อเทคโนโลยีโดยรวม

- การสอดส่องที่ไม่ชอบธรรม (Illegitimate Surveillance) เช่น ระบบ Speech-to-Text ในเรือนจำสหรัฐฯ ที่เรียนรู้ข้อมูลจากคนผิวขาว ทำให้จับสำเนียงคนผิวสีได้ไม่ดีพอ ซึ่งอาจนำไปสู่การรายงานที่ผิดพลาดและการเลือกปฏิบัติ

- ความไม่โปร่งใส (Non-Transparency) เช่น การที่ AI มีปฏิสัมพันธ์คล้าย

มนุษย์มาก ทำให้ผู้ใช้อาจสับสนและพึ่งพา AI มากเกินไป จนอาจนำไปสู่ปัญหาทางจิตวิทยาหรืออันตรายถึงชีวิตได้

- การใช้ข้อมูลโดยมิชอบ (Exploitation of Data) เช่น กรณีการฟ้องร้องเกี่ยวกับการ Scrape ข้อมูล Social Media ไปพัฒนา AI หรือการใช้ข้อมูลของเด็กโดย

ไม่เหมาะสม จึงควรใช้แนวทางอื่น เช่น การใช้ข้อมูลที่สร้างขึ้นโดย AI แทนการใช้ข้อมูลจริง (Synthetic Data) ฯลฯ

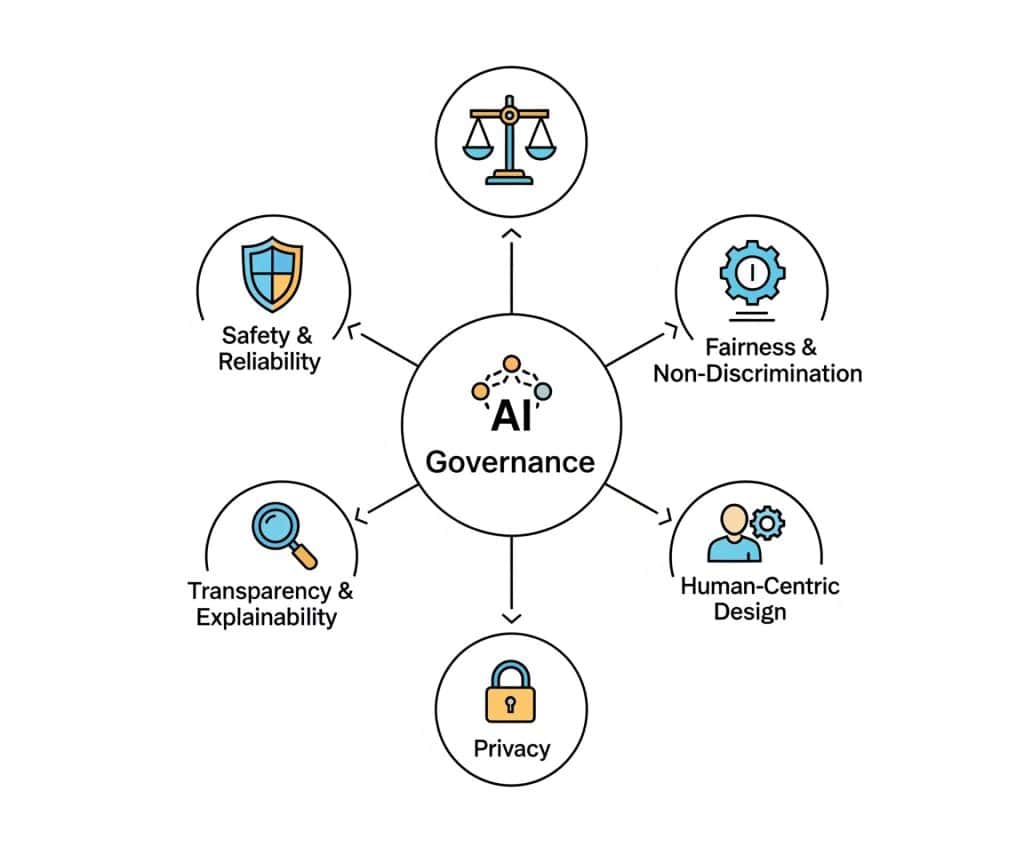

หลักการกำกับดูแล AI (AI Principles)

แนวทางในการพัฒนา ใช้งาน และกำกับดูแลเทคโนโลยี AI คำนึงถึงผลกระทบทางจริยธรรม สังคม และกฎหมาย โดยเน้นให้ AI สร้างประโยชน์ต่อมนุษย์และสังคม พร้อมลดความเสี่ยงและผลกระทบเชิงลบที่อาจเกิดขึ้น ได้แก่

- ความปลอดภัยและความน่าเชื่อถือ (Safety & Reliability) ของระบบ AI ที่เลือกใช้

- ความเป็นธรรมและการไม่เลือกปฏิบัติ (Fairness & Non-Discrimination) ของ AI

จนนำไปสู่การเลือกปฏิบัติ - ความโปร่งใสและการอธิบายได้ (Transparency & Explainability) ของผลลัพธ์จาก

การทำงานของ AI ที่หากเกิดข้อผิดพลาด จะต้องสามารถสืบย้อนกลับและระบุผู้รับผิดชอบ

ได้ชัดเจน - ความเป็นส่วนตัว (Privacy) การใช้ข้อมูลส่วนบุคคลต้องเคารพความเป็นส่วนตัว และมีการป้องกันข้อมูลอย่างเข้มงวด

- การออกแบบโดยยึดมนุษย์เป็นศูนย์กลาง (Human-Centric Design) AI ควรใช้งานง่าย คิดถึงผู้ใช้เป็นหลัก และต้องทำให้ผู้ใช้เข้าใจว่ากำลังสนทนากับคนหรือ AI

ภาพรวม AI Governance ในระดับสากลและไทย

ในระดับสากล โดยเฉพาะสหประชาชาติ (UN) ให้ความสำคัญกับการกำกับดูแล AI

โดยเน้นไปที่ สิทธิมนุษยชน จริยธรรม และความยุติธรรม เป็นหลัก ต่างจากสหรัฐอเมริกา

ที่ขับเคลื่อนด้วยกลไกตลาด เน้นการแข่งขัน ประสิทธิภาพ และนวัตกรรมมากกว่า จีนเน้นการลงทุนโครงสร้างพื้นฐาน และการควบคุมโดยรัฐ และสหภาพยุโรปเน้นการกำกับดูแลเพื่อปกป้องสิทธิเสรีภาพของประชาชน

สำหรับประเทศไทย คาดว่าจะไม่มีการออกกฎหมาย AI ในเร็วๆ นี้ และแนวโน้ม คือ

การพัฒนามาตรฐานอุตสาหกรรมโดยหลายภาคส่วนร่วมกัน ไม่ใช่แค่รัฐบาลเดียว องค์กรจึงควรแสดงให้เห็นว่าการใช้ AI สอดคล้องกับนโยบายเพื่อหลีกเลี่ยงการถูกมองว่าไม่รับผิดชอบต่อสังคม

หรือที่เรียกว่า Social License to Operate และเพื่อประเมินความเสี่ยงของผลิตภัณฑ์ โดยเทียบกับ EU AI Act ที่แบ่งความเสี่ยงเป็น 4 ระดับตามแนวทาง Risk-Based Approach ได้แก่

- ความเสี่ยงที่ยอมรับไม่ได้ (Unacceptable Risk) ความเสี่ยงที่ห้ามใช้ AI โดยเด็ดขาด เช่น การประมวลผลอารมณ์มนุษย์แบบ Real-time โดยเจ้าหน้าที่รัฐ

- ความเสี่ยงสูง (High Risk) ความเสี่ยงจาก AI ที่มีผลกระทบสูง ต้องมีการประเมิน

ความสอดคล้อง (Conformity Assessment) ก่อนใช้งาน เช่น ระบบรถยนต์ไร้คนขับ - ความเสี่ยงจำกัด (Limited Risk) ความเสี่ยงที่อาจมีผลกระทบด้านลบหากใช้ผิดวัตถุประสงค์ ต้องติดตามสิ่งที่เกิดขึ้นจาก AI ได้

- ความเสี่ยงน้อยที่สุด (Minimal Risk) AI ที่ไม่มีความเสี่ยงมากนัก มักจะทำตามระบบปกติ เช่น AI ช่วยจำแนกเอกสาร

โดยสิ่งที่สำคัญคือจะต้องใช้แนวทางในการ “อิงตามความเสี่ยง (Risk-Based)” เพื่อให้เข้าใจประเภทของความเสี่ยง (กฎหมาย จริยธรรม การดำเนินงาน) และใช้แนวทาง Integration-Based เพื่อบูรณาการและพิจารณาร่วมกันจากหลาย ๆ ฝ่ายโดยใช้เครื่องมือและกลไกที่หลากหลาย

บทสรุป

การกำกับดูแล AI ถูกให้ความสำคัญทั้งในระดับสากลและในประเทศไทย โดยมีเป้าหมายเพื่อคุ้มครองสิทธิส่วนบุคคลและสร้างความยุติธรรมในการใช้งาน เทรนด์ทั่วโลกสะท้อนให้เห็นหลายแนวทาง ไม่ว่าจะเป็นการเน้นจริยธรรมและสิทธิมนุษยชนของสหประชาชาติ การขับเคลื่อนด้วยนวัตกรรมในสหรัฐอเมริกา หรือการควบคุมโดยรัฐในจีน ขณะที่สหภาพยุโรปออกกฎหมายเพื่อคุ้มครองเสรีภาพประชาชน สำหรับไทย แม้ยังไม่มีการออกกฎหมาย AI โดยตรง แต่มีแนวโน้มเน้นการพัฒนามาตรฐานร่วมกันจากหลายภาคส่วน องค์กรจึงควรดำเนินงานอย่างโปร่งใสและมีความรับผิดชอบต่อสังคม ควรประเมินความเสี่ยงของ AI ด้วยแนวทางอิงตามความเสี่ยง เพื่อให้มั่นใจว่าสอดคล้องกับมาตรฐานและไม่เกิดผลกระทบเชิงลบ โดยเฉพาะกับระบบที่มีความเสี่ยงสูง ทั้งนี้ การบูรณาการความร่วมมือกับหลายฝ่ายและเลือกใช้เครื่องมือที่เหมาะสมจะช่วยสร้างความเชื่อมั่นในการนำ AI ไปใช้ในสังคมได้อย่างยั่งยืน

เอกสารอ้างอิง

https://arxiv.org/pdf/2407.01294

https://www.aiaaic.org/aiaaic-repository

https://doi.org/10.1007/s13347-021-00474-3

https://s41721.pcdn.co/wp-content/uploads/2021/06/Executive-Summary-2022-Report.pdf

https://aiindex.stanford.edu/wp-content/uploads/2023/04/HAI_AI-Index-Report_2023.pdf

Kajohnpon Pakdeechuleebaht

- This author does not have any more posts.